Ma boîte gmail reçoit un volume important d’e-mails récurrents. Une partie est utile (transactionnel, suivi, achats). Une autre partie s’accumule et crée du bruit de fond.

J’ai donc construit mymail dna, un outil d’analyse attentionnelle, pour objectiver ce flux entrant et transformer la boîte mail en source de données exploitable (au lieu d’un stock difficile à traiter).

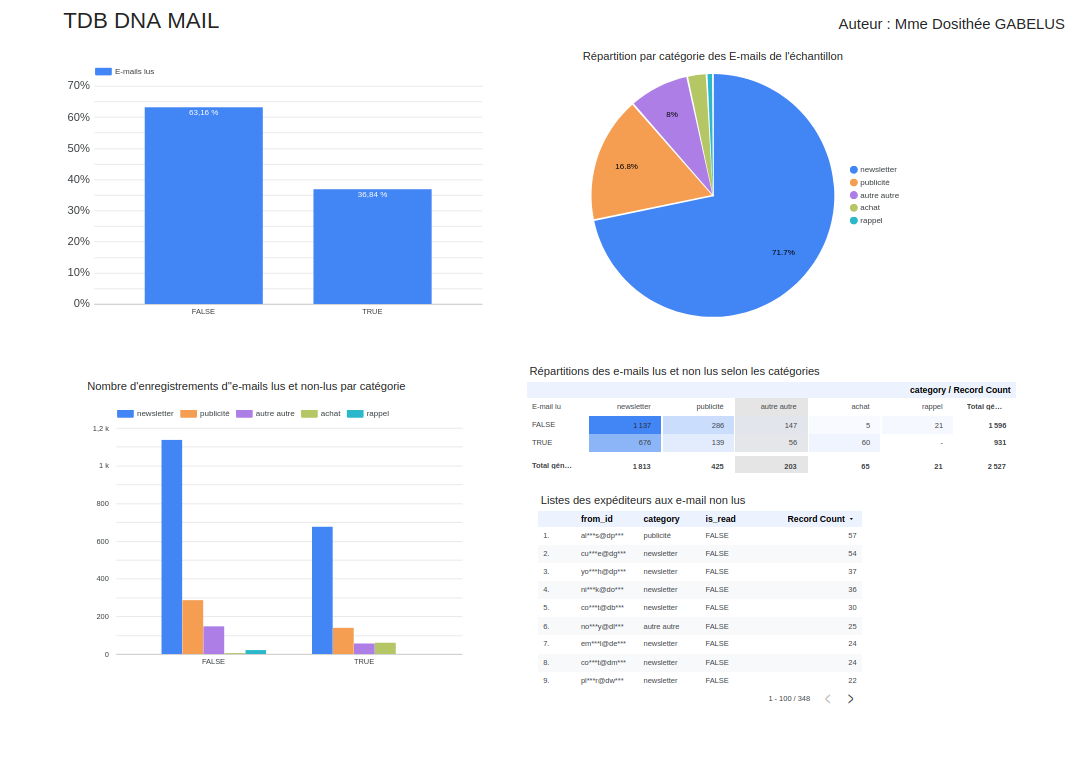

L’analyse présentée ici porte sur un échantillon de 2 527 e-mails, enrichi et catégorisé via un workflow automatisé, puis restitué dans un tableau de bord looker studio et un rapport de synthèse.

L’objectif n’était pas seulement de suivre mes interactions, mais d’identifier mes priorités attentionnelles à partir de signaux observables (volume, lus vs non lus, catégories) et de traduire ces observations en actions concrètes de tri et de réduction du bruit.

Ce projet illustre comment l’automatisation et l’analyse de données peuvent être utilisées pour optimiser la gestion d’une boîte mail, soutenir une démarche de connaissance de soi, et servir des usages marketing ou de veille (segmentation, priorisation, hygiène des flux).